Cakewalk by Bandlab TTS-1で純正律

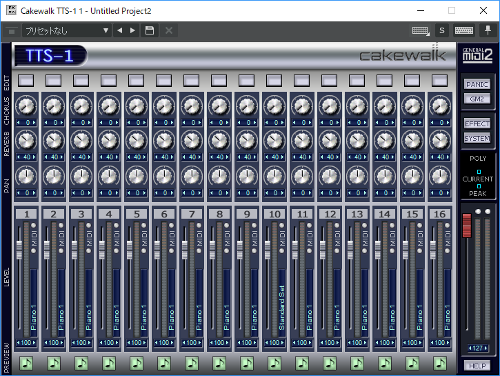

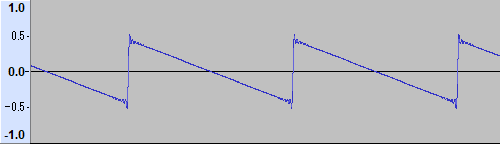

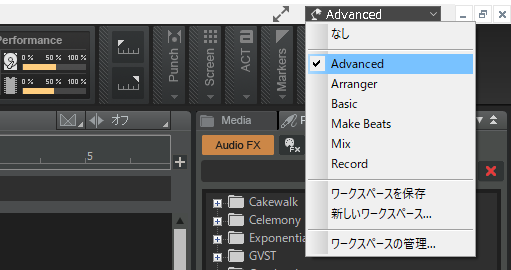

TTS-1を使って純正律にチャレンジしてみた。 やり方がズバリ書いてあるサイトもなく、オンライン・ヘルプを読みながら、MIDIの勉強もしつつ、という感じなので、ちゃんと理解しているわけではない。 方法としては、TTS-1のユニバーサル・ノンリアルタイム・システム・エクスクルーシブ・メッセージを使用して、 C~Bまでの12音について、各ピッチを指定することで実現してみた。 このユニバーサル・システム・エクスクルーシブ・メッセージは元々メーカーごとに独自の機能を実現するためのシステム・エクスクルーシブを、互換性を確保するためユニバーサルを追加して各社共通のMIDI規定となったという経緯がある。言葉的にエクスクルーシブで、ユニバーサルって矛盾してないか? まずCakewalkのワークスペースをAdvance等にする。初期設定ではBasicになっていてイベントリストの表示ができないため。 TTS-1のトラックを作成し、そのトラックから下図のようにイベントリストを選択する。 イベントリストのプラスアイコンをクリックして1行新規で作る。今回はトラックの頭に情報を入れてみた。これによって再生するときに情報が読み込まれて音律が適用されるので。 種類のNoteというところをクリックすると下図のようにウインドウが開くので、「特別」の「SysxData」を選択しOKボタンを押す。 データのところにスケール/オクターブ・チューニング情報を書き込む。 絵では、とりあえず下記の純正律を入れてみた。 純正律 key = C F0 7E 7F 08 08 40 00 7F 40 38 44 50 32 3E 36 42 4E 30 4E 34 F7 これで一度再生すれば、TTS-1に情報が送られ、純正律になる。 音はこんな感じで、和音に濁りがない。一度途切れてから平均律でも鳴らしているので、明らかな差があることが確認できると思う。 音色は、TTS-1のサイン波を使ってみた。アタックやらモジュレーションを調整すればこういう実験にも十分使える。 データの意味 システム・エクスクルーシブ・メッセージは、最初にF0で、最後にF7にするのがお約束。2番目以降はTTS-1のオンライン・ヘルプによる